O QwQ-32B foi anunciado no dia 5 de março de 2025, pela equipa Qwen do grupo Alibaba, como um novo modelo de IA, que com “apenas” 32 mil milhões de parâmetros, rivaliza com modelos de raciocínio avançados como o DeepSeek-R1.

Isto quer dizer que apesar de ter menos parâmetros (32 mil milhões vs. 671 mil milhões do DeepSeek-R1, dos quais apenas 37 mil milhões estão ativos) está a alcançar resultados impressionantes em benchmarks.

O Que é o QwQ-32B e Porque Está a Causar Tanto Impacto

O QwQ-32B é um modelo de linguagem de grande escala (LLM) criado para aprimorar as capacidades de raciocínio da IA.

Com “apenas” 32 mil milhões de parâmetros, uma fração do tamanho de muitos modelos de IA, como o DeepSeek-R1, este novo modelo de IA, ao utilizar técnicas avançadas de escalonamento de aprendizagem por reforço (RL), está a conseguir um desempenho impressionante em tarefas de raciocínio, desde a resolução de problemas matemáticos até à programação e compreensão de linguagem natural. Ou seja, o QwQ-32B está a conseguir um equilíbrio ideal entre complexidade e eficiência.

O QwQ-32B suporta até 131.072 tokens, o que lhe permite compreender e criar textos extensos sem perda de coerência.

Este modelo de IA está disponível de forma open source sob a licença Apache 2.0, o que significa que tu podes aceder ao código, personalizá-lo e integrá-lo nos teus próprios projetos.

O QwQ-32B foi construído com base no Qwen2.5-32B, incorporando inovações que o tornam um dos modelos de raciocínio mais eficientes do mercado.

Estas características tornam o QwQ-32B um modelo de IA apto para diversas aplicações, desde assistentes de IA até sistemas de recomendação e análise de dados.

Como o QwQ-32B Se Compara com o DeepSeek-R1

O DeepSeek-R1, lançado em janeiro de 2025 pela startup chinesa DeepSeek, destacou-se por ser um LLM focado em tarefas complexas como raciocínio, programação e matemática e por estar disponível de forma open source. O DeepSeek-R1 alcançou um desempenho comparável ao OpenAI o1.

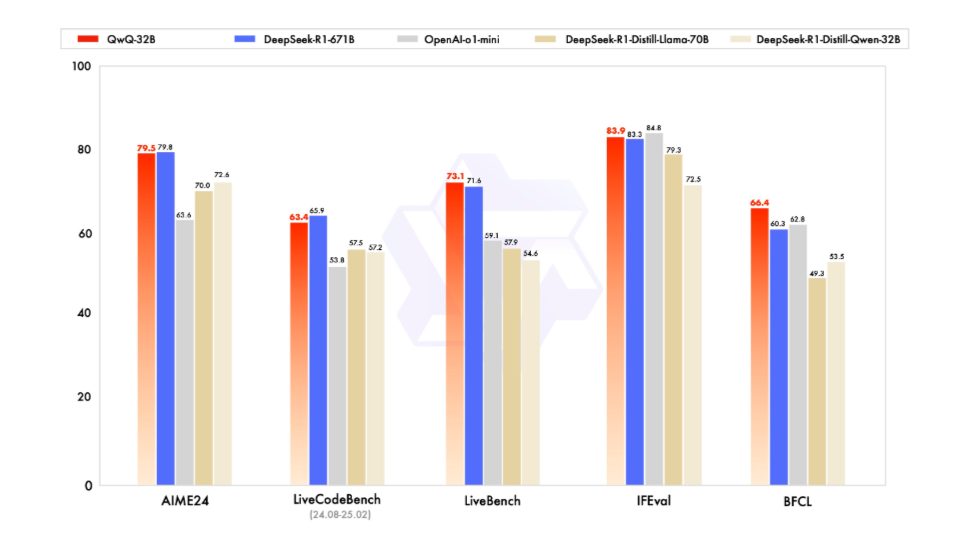

Sucede que o QwQ-32B vai mais longe e com “apenas” 32 mil milhões de parâmetros, não só consegue igualar o desempenho do DeepSeek-R1 como, em alguns casos, o supera.

Os resultados em benchmarks, como o AIME24 (resolução de problemas matemáticos avançados), LiveCodeBench (habilidades de programação em cenários reais), LiveBench (superação de limitações de outros benchmarks), IFEval (Instruction-Following Eval, capacidade de seguir instruções) e BFCL (Benchmark for Few-Shot Learning, capacidade de aprender a partir de poucos exemplos), destacam o desempenho do QwQ-32B em comparação com outros modelos significativamente maiores. O que sugere que a eficiência não está no tamanho, mas na forma como foi treinado.

Limitações Atuais do QwQ-32B

Embora o QwQ-32B apresente avanços significativos, é importante não esquecer que é uma versão preview, pelo que apresenta algumas limitações:

- Mistura de Idiomas: Em algumas situações, o modelo pode misturar diferentes idiomas na mesma resposta.

- Loops de Raciocínio: Pode entrar em ciclos de raciocínio repetitivos, afetando a coerência das respostas.

- Medidas de Segurança: Necessita de aperfeiçoar as suas medidas de segurança para garantir respostas lógicas, confiáveis e seguras.

A equipa Qwen está ciente destas questões e está a trabalhar diariamente para melhorar o modelo, visando dirimir essas limitações em futuras atualizações.

Importância do QWQ-32B para o Futuro da IA

O lançamento do QwQ-32B marca um avanço significativo em modelos de raciocínio, ao demonstrar que um modelo com “apenas” 32 mil milhões de parâmetros pode fazer frente a modelos líderes como DeepSeek-R1 e OpenAI o1-mini. A equipa Qwen do grupo Alibaba está a desafiar a ideia de que o tamanho é sinónimo de desempenho. Este novo modelo de IA abre o caminho para soluções mais acessíveis e sustentáveis.

A abordagem open source do QwQ-32B combinada com a sua performance em benchmarks torna-o uma escolha interessante para o desenvolvimento de software, para ajudar na área da edução e na pesquisa científica e para otimizar fluxos de trabalho em empresas.

O QwQ-32B não é apenas um novo modelo de IA, é uma demonstração poderosa de como a inovação e a eficiência podem redefinir os padrões da indústria.

Tu acabaste de descobrir o potencial transformador do QwQ-32B e se queres ser um pioneiro na utilização deste novo modelo de IA, experimenta-o através do Hugging Face, ModelScope ou Qwen Chat e deixa o teu feedback abaixo nos comentários.