A Microsoft lançou recentemente o Phi-4 Multimodal, um modelo de IA multimodal pertencente à inovadora Phi Family da Microsoft, que é capaz de processar texto, imagens e voz simultaneamente, o que lhe permite oferecer um desempenho excecional em ambientes com recursos computacionais limitados.

Este modelo da Microsoft representa um avanço significativo na área de IA multimodal.

Índice

O Que é o Phi-4 Multimodal e o Que o Torna Tão Especial

O Phi-4 Multimodal é um Small Language Model (SLM) desenvolvido pela Microsoft, pertencente à família Phi, conhecida pela sua eficiência e desempenho em tarefas complexas. Com 5,6 mil milhões de parâmetros, diferentemente do Phi-4 que se destaca em raciocínio complexo, especialmente em matemática, o Phi-4 Multimodal destaca-se pela sua capacidade de processar múltiplas modalidades de dados como texto, imagens e voz, tudo simultaneamente.

Esta capacidade multimodal é alcançada através de uma arquitetura baseada em transformer neural network, especificamente um decoder-only transformer, com um contexto de 128K tokens, ideal para processar dados longos e complexos.

Um aspecto interessante é que ele utiliza a técnica de “mixture-of-LoRAs” (Low-Rank Adaptations), que permite integrar diferentes tipos de entrada, como texto, áudio e visão, em um único espaço de representação, eliminando a necessidade de pipelines separados e complexos ou modelos dedicados para cada modalidade. Isto significa que podes pensar nele como uma pessoa multilingue que entende fala, escrita, imagens e gestos ao mesmo tempo, sem precisar mudar de “modo”, tudo acontece de forma fluida e integrada. Desta forma, este modelo de IA permite uma interação mais rica e dinâmica.

O modelo foi treinado com datasets sintéticos de alta qualidade, filtrados de sites públicos, livros académicos e conjuntos de perguntas e respostas, combinados com técnicas de pós-treino como supervised fine-tuning (SFT), direct preference optimization (DPO) e reinforcement learning from human feedback (RLHF). Estas técnicas garantem que o modelo siga instruções precisas, mantenha medidas de segurança e melhore a sua adesão a contextos reais.

Desempenho do Phi-4 Multimodal

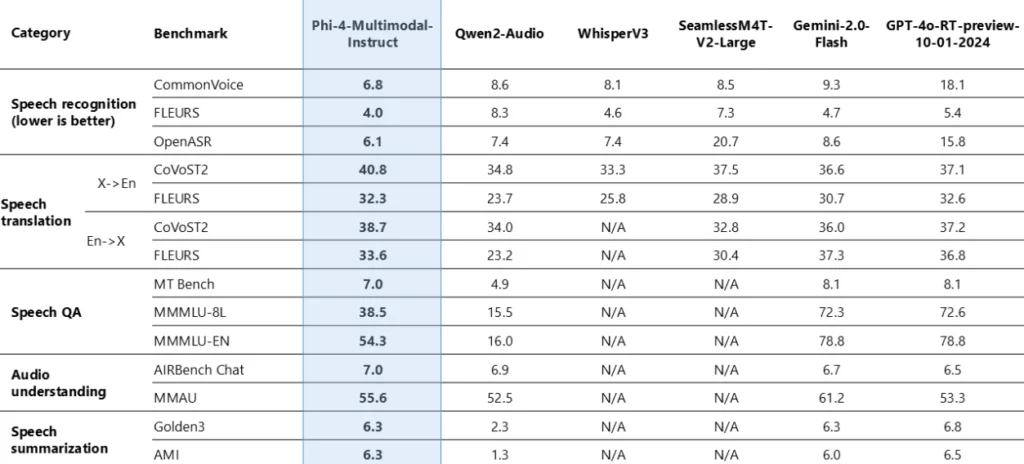

O Phi-4 Multimodal tem um desempenho impressionante em tarefas específicas, como reconhecimento automático de fala (ASR), onde lidera o ranking do Hugging Face OpenASR com uma taxa de erro de palavra de 6,14%, superando modelos especializados como o WhisperV3. Além disso, também é capaz de realizar tradução de fala, sumarização de fala e resposta a perguntas visuais, mostrando sua versatilidade.

Um dos pontos fortes é o suporte multilingue. Para texto, suporta uma ampla diversidade de idiomas, como árabe, chinês, checo, dinamarquês, holandês, inglês, finlandês, francês, alemão, hebraico, húngaro, italiano, japonês, coreano, norueguês, polaco, português, russo, espanhol, sueco, tailandês, turco e ucraniano. Para fala, inclui inglês, espanhol, francês, alemão, italiano, português, entre outros. A visão, embora mais genérica, permite produzir descrições textuais em línguas suportadas, o que o torna ideal para uso global.

A eficiência deste modelo de IA multimodal é um ponto forte, podes executá-lo em gadgets edge, devido ao seu tamanho compacto e baixa latência, o que é perfeito para cenários onde a privacidade de dados é crucial ou onde não há conexão constante à internet. Isto abre portas para aplicações em tempo real, como chatbots multimodais ou assistentes de saúde que analisam imagens médicas e descrições verbais.

Um detalhe inesperado é que o Phi-4 Multimodal está disponível de forma open source sob a licença MIT, o que significa que podes usá-lo para fins comerciais ou de pesquisa sem restrições significativas.

Está acessível em plataformas como Hugging Face e Azure AI Foundry, o que facilita o acesso a programadores e pesquisadores. Esta abertura pode acelerar inovações, permitindo que mais pessoas personalizem o modelo para as suas necessidades específicas.

Vantagens e Benefícios do Phi-4 Multimodal

As vantagens do Phi-4 Multimodal incluem:

- Eficiência Computacional: Pode ser implementado em gadgets com recursos limitados, reduzindo custos e consumo energético, alinhado com os princípios de IA responsável da Microsoft, como sustentabilidade e acessibilidade.

- Desempenho Competitivo: Apesar do tamanho, supera modelos comparáveis em tarefas específicas, como ASR, e compete com modelos especializados em certas métricas, como mostram os benchmarks internos e externos.

- Flexibilidade: Suporta implementações em cloud, edge e on device, o que oferece flexibilidade para diferentes cenários, desde chatbots em tempo real até sistemas de saúde em áreas remotas.

- Acessibilidade Global: O suporte multilingue e multimodal torna-o útil para aplicações em mercados diversos, especialmente em regiões com múltiplas línguas oficiais, como a Europa.

Como Podes Usar o Phi-4 Multimodal

O Phi-4 Multimodal tem potencial para transformar várias indústrias:

- Serviços de Atendimento ao Cliente: Imagina um chatbot que podes contactar por voz, enviar uma imagem do problema e receber uma solução detalhada em texto. É perfeito para apoio técnico, onde podes descrever verbalmente um problema e mostrar uma captura de ecrã e o modelo compreende ambos para oferecer uma resposta rápida.

- Educação e Aprendizagem de Idiomas: Pode ser usado em Apps de educação para criar aulas interativas, combinando texto, áudio e imagens. Por exemplo, um explicador de um idioma pode mostrar uma imagem, pedir para descreveres em voz alta e corrigir a tua pronúncia em tempo real, tudo num único modelo.

- Saúde e Análise de Imagens Médicas: Em cenários de saúde, pode analisar imagens médicas, como radiografias e combinar com descrições verbais de sintomas para ajudar no diagnóstico.

- Setor Automóvel: Pode ser utilizado como assistente de bordo, pois é capaz de entender ordens e reconhecer gestos dos condutores.

Comparação com Outros Modelos

Em comparação com modelos multimodais, como o ChatGPT-4o da OpenAI, o Phi-4 Multimodal oferece uma alternativa mais eficiente. Enquanto o ChatGPT-4o requer recursos computacionais significativos, o Phi-4 Multimodal pode ser executado localmente, reduzindo custos e latência. Benchmarks sugerem que, em tarefas como ASR, ele supera modelos como WhisperV3, e em algumas métricas, compete com modelos como Gemini-1.5-Flash e GPT-4o-realtime-preview em tarefas de QA de fala.

Outros modelos multimodais, como os da série Gemma do Google, também são otimizados para hardware de consumo, mas o Phi-4 Multimodal destaca-se pela sua capacidade de ser implementado em edge devices, o que não é comum em modelos maiores. Esta eficiência faz dele uma escolha atraente para programadores que procuram soluções acessíveis.

Tabela Comparativa entre o Phi-4 Multimodal e outros Modelos

Desliza horizontalmente para ver toda a tabela em dispositivos móveis

| Modelo | Parâmetros | Modalidades | Eficiência | Multilingue | Disponibilidade |

|---|---|---|---|---|---|

| Phi-4 Multimodal | 5,6B | Texto, Imagem, Voz | Alta (edge ready) | Amplo | Open source (MIT) |

| GPT-4o | ~1,76T | Texto, Imagem, Voz | Baixa (cloud heavy) | Limitado | Proprietário |

| Gemini-1.5-Flash | Não divulgado | Texto, Imagem, Voz | Média | Amplo | Proprietário |

| WhisperV3 | Não divulgado | Voz | Média | Limitado | Open source |

Porque É Relevante para o Futuro da IA

Devido à sua eficiência, desempenho e acessibilidade, o Phi-4 Multimodal da Microsoft representa um marco significativo para definir o futuro das IAs multimodais.

Com a sua capacidade de processar texto, imagens e voz em gadgets edge, abre portas a aplicações mais intuitivas em áreas como atendimento ao cliente, educação e saúde, entre outras.

Se gostas de explorar o mundo da IA, não percas as novidades da IA&A e mergulha no potencial transformador do Phi-4 Multimodal! Esta tecnologia inovadora pode mudar a forma como usas a IA no teu dia a dia. Explora agora como integrá-la e dá um salto no teu desempenho tecnológico. Já usaste o Phi-4 Multimodal ou outro modelo de IA multimodal? Partilha comigo nos comentários as tuas experiências ou ideias, quero saber como estás a revolucionar o teu trabalho ou rotina com a IA!